Aluxo Referenzen

Bei der Durchsicht der Referenen ist mir aufgefallen, dass auch einige Lösungen die auf WordPress basieren dabei sind. Das ist für mich eine klare Bestätigung meiner eigenen Einschätzung, dass WordPress einfach optimal geeignet ist, ein CMS System aufzusetzen,

- dass schnell und einfach zu installieren ist,

- dass sofort und ohne viel Schulungsaufwand einzusetzen ist,

- dass für Designer sehr leicht anzupassen ist,

- dass für Entwickler schnell um weitere individuelle Funktionen ergänzt werden kann und

- dass für den Mitarbeiter einfach zu bedienen ist.

WordPress im Einsatz

WordPress hat längst den Schritt vom Blog System zum vollwertigen CMS gemacht und wird von einer großen Community unterstützt. Den Vergleich mit anderen Open Source CMS System wie z.B. Joomla!, Typo3 CMS, Plone CMS, Drupal und Contao braucht WordPress jedenfalls nicht zu scheuen. Neben den oben aufgelisteten Pluspunkten, hat WordPress auch noch sehr viele andere Vorteile wie z.B. gute Unterstützung für Suchmaschinenoptimierung, gute Performance, regelmäßige Updates, etc.

Aber das ist ein ganz anderes Thema. Ich bin jedenfalls über jede Agentur erfreut, die sich für WordPress entscheidet und nicht dieses komische Typo3 nutzt, mit dem ich selbst nie wirklich warm geworden bin. (Sorry, aber Typo3 ist echt nicht meine Welt)

Online Marketing bei Aluxo

Aluxo kümmert sich nicht nur um die technische Umsetzung und das Design, sondern auch um das Online Marketing der Webseite. So kann schon bei der Konzeption und der Umsetzung darauf geachtet werden, dass die Webseite den Suchmaschinen-Optimierer bei der Onpage Optimierung und der Offpage Optimierung ideal unterstützt. Dieser Wettbewerbsvorteil birgt einen wesentlichen Vorteil.

- Deutlich mehr Besucher.

Im allgemeinen wird aktuell davon ausgegangen, dass ca. 80%-90% der Besucher einer Webseite über Suchmaschinen den Weg zu einem Online Angebot finden und daher ist es wichtig mit den richtigen Suchbegriffen (z.B. Internetagentur Heidelberg und Webdesign Heidelberg für Aluxo) bei Google gut gelistet zu sein. Um dies zu erreichen muss eine Webseite für Suchmaschinen wie Google optimiert werden. Da ist es gut, dass Aluxo in den Bereich auf eine langjährige Erfahrung zurückgreifen kann und weiß, wie man bei Google auf die Top Positionen kommt.

Fazit:

Aluxo bietet technische Lösungen als Gesamtpaket von der Programmierung über das Design bis zum Webhosting als Full-Service Provider und kompetenten Ansprechpartner für alle Fragen rund um das Online Business.

Erreichen können Sie Aluxo unter:

Aluxo | Ihre Internetagentur in Heidelberg

Tel.: +49 6221 72 59 468

E-Mail: [email protected]

Web: www.aluxo.de

No related posts.

]]>Dem Online Shop fehlt der Verkäufer

Anders sieht es aber bei Online Shops aus. Hier sitzt der Kunde vor einem Computer oder einem anderen Endgerät, wie z.B. einem iPhone oder einem Tablet, um sich im Internet umzusehen oder nach Artikeln zu suchen. Leider ist es nicht möglich, einen Verkäufer neben den Kunden zu setzen, um ihn bei seinen Einkaufsentscheidungen zu lenken und ihm so die Qual der Wahl zu erleichtern. Allerdings ist es möglich, das Surf-Verhalten des Kunden auszuwerten und daraus Informationen abzuleiten. So kann man anhand des Suchbegriffs schnell erkennen, ob ein Kunde sich über ein Produkt informieren möchte, oder ob er ein Produkt kaufen möchte.

Beispiel:

- Samsung Galaxy S III Testbericht

- Samsung Galaxy S III Preis

Im ersten Fall sucht der Kunde nach Informationen und im zweiten Fall nach einem Anbieter mit dem besten Preis.

Dies ist nur ein einfaches Beispiel für die Datenanalyse. Es gibt hier vielfältige Möglichkeiten, die es ermöglichen anhand von ehemaligen Besuchen auf der Webseite, oder abgeschlossenen Warenkörben und betrachteten Produkten, unter anderem das Geschlecht, das ungefähre Alter und bestimmte Vorlieben (Technik, Sport, Musik, Filme, etc.) zu identifizieren.

Wofür interessiert sich der Besucher?

Ziel jeder Analyse dieser Daten ist es anhand von Mustern und bekannten Strukturen Eigenschaften zu erkennen und Zusammenhänge zu möglichen Interessen und Vorlieben zu dem jeweiligen Besucher zu finden. Ein sehr gutes Beispiel dafür liefert uns z.B. Google AdWords.

Was weiß Google AdWords über uns?

AdWords Anzeigen sieht man heute nicht nur auf den Webseiten von Google sondern auch auf anderen Webseiten und so kann Google sehr leicht unheimlich viele Daten über uns sammeln und so ein Persönlichkeitsprofil erstellen, um dann die optimalen Anzeigen auf den Webseiten darzustellen. Wer wie ich Google Web-Mail nutzt, der hat sicher schon mal den kleinen Hinweis oben rechts entdeckt “Warum sehe ich diese Anzeige?”. Die Frage ist berechtigt, aber wird ja auch direkt beantwortet. Wenn man auf den Link klickt, bekommt man die Antwort.

Zitat Google:

„Die Auswahl dieser Anzeige basiert auf den E-Mails in Ihrem Postfach. Im Anzeigenvorgaben-Manager finden Sie weitere Informationen und können Anzeigen von bestimmten Werbetreibenden blockieren oder die Anzeigenpersonalisierung ganz deaktivieren.“

Das bedeutet, dass hier ein Google Algorithmus die Mails im Posteingang scannt und dann eine Kundenanalyse durchführt. Ziel der Analyse ist es, das richtige Produkt zum richtigen Zeitpunkt zu bewerben.

Produktempfehlungen im Online Shop

Ein anderes Beispiel sind Produktempfehlungen in Online-Shops. Diese Produktempfehlungen werden in vielen Fällen mit Hilfe sogenannter Recommender Systeme erzeugt und verfolgen das gleiche Ziel wie der Google Algorithmus den AdWords verwendet. Diese Empfehlungs-Systeme versuchen Objekte in Relation zueinander zu bringen und die besten Empfehlungen werden dann im Online Shop als Produktempfehlungen angezeigt. Dabei wird zwischen persönlichen und anonymen Empfehlungen unterschieden. Anonyme Produktempfehlungen sind für alle Kunden gleich. Sie sind unabhängig von persönlichen Interessen und Vorlieben und bauen in den meisten Fällen ausschließlich auf der Ähnlichkeit von Produkten auf. Die personalisierten Produktempfehlungen werden hier speziell für einen Kunden erzeugt. Hier können unter anderem abgeschlossene Warenkörbe, aufgerufene Produkte oder Suchanfragen als Datenbasis verwendet werden. Die verwendeten Muster bringen oft nicht das optimale Ergebnis und sind durch gezieltes “Fehlverhalten” leicht zu beeinflussen. Allerdings sind diese Systeme oft sehr lernfähig und passen sich schnell den Gegebenheiten an. Daher werden sie sehr gerne eingesetzt, auch wenn die Empfehlungen nur zu 60% oder 80% korrekt sind und man sich als Kunde über die anderen Empfehlungen einfach nur wundern kann.

Kundenanalyse für den Erfolgreichen Online Shop

Erfolgreiche Webseiten und Online Shops müssen hier sehr viele Daten analysieren und bewerten, daher lohnt es sich in vielen Fällen, die Datenanalyse der Daten auf externen Systemen durchzuführen und so die eigenen Ressourcen zu schonen. Gibt man die Daten an einen externen Dienstleister weiter, erfolgt die Kundenanalyse auf den Systemen des Dienstleisters, der seine Infrastruktur auf die spezifischen Anforderungen der Datenanalyse ausgelegt hat und somit optimale Ergebnisse erreichen kann. Idealerweise werden hier die Daten sogar in Echtzeit analysiert und können so noch schneller die Ergebnisse einsehen und darauf reagieren.

Fazit:

Mit Hilfe der Informationen die man in seiner Datenbank über Produkte, Dienstleistungen, Kategorien, Schlagworte und anderen Attributen hat, kann man schon sehr gute Produktbeziehungen herstellen. Aber die Nutzung der Kundendaten schafft wesentlich bessere Ergebnisse und damit eine deutliche Verbesserung der Planbarkeit der Verkäufe und Umsätze.

Related posts:

- Backlinks aus Whois Portalen (Teil 2) Die Analyse Wie im ersten Teil angekündigt, habe ich nun ein erstes Ergebnis vorliegen. Die 2,99 Euro, die ich investiert habe in...

- SEMSEO 2011: Conversion Rate Optimierung Nach der Mittagspause ging es dann direkt weiter mit „Conversion Rate Optimierung“. Angefangen hat hier Alexander Beck. In seinem Zeit-Slot...

- Google AdWords Werbung mit KubaSeoTräume Wer hätte das gedacht. Ich gebe KubaSeoTräume bei Google ein um zu sehen, wie die Top 10 sich über das...

Auf der Arbeit muss ich PHP oft in Schutz nehmen da es in Enterprise Projekten noch nicht das Ansehen hat wie es Java aktuell hat. Aber genau die gleiche Situation habe ich schon einmal erlebt. Als Ende der 90er Jahre Java noch ganz neu war und wir alle noch mit C oder C++ programmiert haben. Damals hat das Debuggen von Pointer Arithmetik mehr Zeit benötigt, als es gut war für jedes Projekt, statt ant gab es make und Webseiten konnten mit CGI oder FastCGI in C oder sogar mit Shell Scripten umgesetzt werden. Aber das ist lange her (zum Glück). Heute hat man dank moderner Programmiersprachen und umfangreicher IDEs Möglichkeiten, die vor 10 Jahren noch nicht denkbar waren.

Doch zurück zum Thema “Java vs. PHP”.

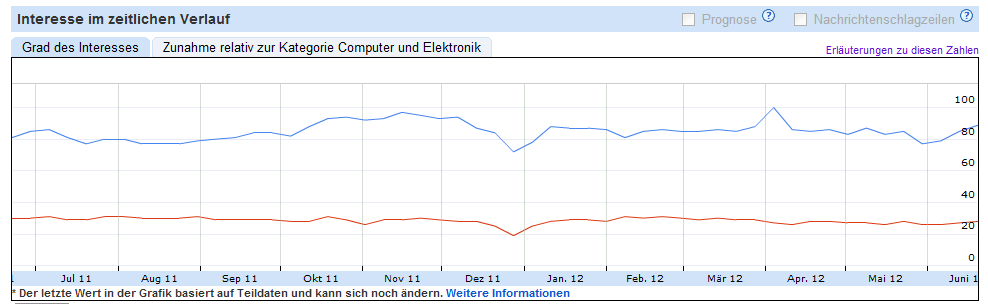

Zum Vergleich habe ich mal mit Hilfe von Google Insights das Suchvolumen bei Google in der Kategorie Computer und Elektronik hier als Bild eingefügt. Die blaue Linie ist das Suchvolumen für den Begriff java und die rote Kurve für den Begriff PHP. Es ist deutlich zu erkennen, dass Java in Deutschland ein wesentlich höheres Suchvolumen hat als PHP.

Ganz Klarer Gewinner ist Java, doch was sagt die Kurve eigentlich aus? Denn eigentlich ist es kein Kriterium für die Auswahl der Programmiersprache, wie oft danach gegoogelt wurde. Statt dessen sollte man sich überlegen, welche Programmiersprache einen bei der Arbeit am besten unterstützt. Heute hat man einen Application-Server, Load-Balancer und so tolle Werkzeuge wie Maven, Hudson und JUnit, die einem das Leben einfacher machen. Trotzdem ist es in vielen Fällen einfacher, mal schnell ein PHP Script zu schreiben, als eine Web-Anwendung in Java zu realisieren und genau da liegt der große Vorteil der Programmiersprache PHP. PHP ist einfacher, schneller und mittlerweile auch sehr weit verbreitet bei Open Source Projekten. Die API ist sehr intuitiv zu verstehen und selbst BWL Stundenten haben im Studium Kontakt damit und kommen damit klar.

Heute ist bei so gut wie jedem Webhoster auch PHP und eine MySQL Datenbank dabei und so kann sich jeder, der einen Text-Editor bedienen kann auch eine Web Anwendung programmieren. Auch wenn es nur ein einfaches Gästebuch oder ein Counter oder sonst was ist. Genau dafür ist PHP wesentlich besser geeignet als Java.

Aber was ist mit wirklich großen Projekten, an denen mehrere Duzend Mitarbeiter über einen längeren Zeitraum entwickeln müssen? Tja, da ich leider keine Erfahrung damit habe, größere Projekte in PHP umzusetzen bin ich also auf eure Mithilfe angewiesen. Was ist eurer Meinung nach besser geeignet, ein großes Projekte umzusetzen Java oder PHP?

Related posts:

- Java Network Monitor FAQ Wozu ist der Java Network Monitor zu gebrauchen? Der Java Network Monitor unterstützt Administratoren und Entwicklern bei der Entwicklung und...

- Java Network Monitor Der Java Network Monitor macht die gezielte Netzwerk-Überwachung und Analyse zum Kinderspiel Der Java Network Monitor ist ein kleines schlankes...

- Mobile Games – Spieleprogrammierung für Handys mit Java ME von Thomas Lucka Vom Hello World bis zum fortgeschrittenen Multiplayer Game. In dem Buch “Spieleprogrammierung für Handys mit Java ME” von Thomas Lucka...

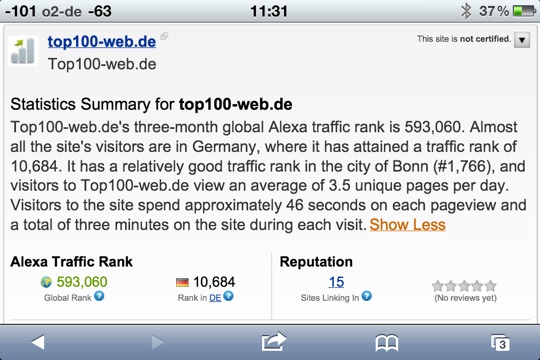

So wie es scheint wird das Projekt sehr gut angenommen. Aktuell ist das Projekt seit weniger als einem Monat online und schon habe ich fast 100 Anmeldungen und einen Alexa Traffic Rank (De) von 10.684. Das ist weit mehr als ich erwartet hätte und steigert meine Motivation, das Projekt weiter zu verfolgen. Die Domain hat aktuell einen PageRank 5 und selbst die Rich Snippets für die Bewertungen sind bei Google zu finden.

Ein paar kleinere Probleme habe ich noch mit der Facebook Anbindung, aber das werde ich auch noch hin bekommen. Aber nicht heute. In meinem Zustand kann ich mich nicht so gut konzentrieren und würde vermutlich mehr Fehler einbauen als ausbauen. ![]()

Alles in allem bin ich, aber sehr zufrieden mit dem Projekt und hoffe, dass sich die Topliste für jeden Webmaster der seine Webseite eingetragen hat lohnt und sowohl neue Besucher als auch einen Ranking Vorteil bei Google und Co. liefert. Also bitte weiter eintragen. denn je größer die Community umso größer ist der Erfolg für die Topliste und alle Mitglieder.

PS: Danke noch mal an alle, die sich mit ihrer Webseite in die top100-web.de eingetragen haben. Ohne die Mitglieder ist eine Topliste nur eine leere Webseite ohne einen Nutzen. ![]()

Related posts:

- Top100-web.de – Die Web 2.0 Topliste Toplisten gibt es im Internet wie Sand am Meer. Die meisten sind schon sehr alt und nicht mehr auf dem...

- Content ist King Wie jeder gute SEO weiß. Content ist King. Ich sitze also wieder im Zug und checke mein Ranking. Aktuell stehe...

Da ich immer häufiger folgenden Fehler auftritt “Quota Exceeded. Please see http://code.google.com/apis/websearch”, weil die Google API nur eine Bestimmte Anzahl an Zugriffen pro Zeit zulässt, habe ich das Skript auch zum Download freigegeben. Die Sourcen kann sich jeder unter https://github.com/msoftware/pinguin-check herunterladen und auf dem eigenen Webserver installieren um dort einen Google Pinguin Check zu machen.

Fragen und Anregungen wie immer gerne hier. ![]()

Related posts:

- Wichtiges Google Update! Wie Matt Cuts im offiziellen Webmaster Blog ankündigt, steht ein weltweites Google Update bevor, das in Deutschland ca. 3% der...

- Gelöschte Domains Finden – HowTo Jeder SEO, der sich schon mal mit gelöschten Domains beschäftigt hat, weiß, dass man 3 Dinge benötigt, um gelöschte Domains...

- Google +1 Nachdem ich eine E-Mail von Google bekommen habe in der mich die Google Webmaster Tools darüber informiert haben, dass der...

Dieser kleine Bericht ist kein Tutorial oder eine Anleitung oder sowas. Es ist eher ein Roman – die Geschichte, wie ich Magento2 kennengelernt habe. ![]()

Installiert habe ich also erst mal:

1. xampp-win32-1.7.7-VC9-installer.exe

Quelle: http://dfn.dl.sourceforge.net/project/xampp/XAMPP Windows/1.7.7/xampp-win32-1.7.7-VC9-installer.exe

Weitere Informationen zu xampp unter: http://www.apachefriends.org/

2. Git-1.7.10-preview20120409.exe

Quelle: http://msysgit.googlecode.com/files/Git-1.7.10-preview20120409.exe

Informationen dazu unter: http://msysgit.github.com/

Dann habe ich das Magento2 Repository unter https://github.com/magento/magento2 geforkt und mit der Git-BASH ein lokal geclonnt.

git clone https://[email protected]/msoftware/magento2.git

Das gleiche habe ich mit dem Repository von netresearch gemacht. Erst ein fork und dann git clone (https://github.com/netresearch/jumpstorm). Hier ist aber dringend darauf zu achten, dass ein rekursives clone durchgeführt wird. Da aus dem jumpstore Repository heraus auch noch andere Repositorys benötigt werden. Z.B. die Dateien unter /lib/Symfony/Component. Das es sich hier um verknüpfte Repositories handelt, kann man unter github.con auch gut an dem kleinen grünen Icon erkennen (z.B. hier https://github.com/msoftware/jumpstorm/tree/master/lib/Symfony/Component).

Und weil es so einen Spaß macht, habe ich auch direkt mal das FIREGENTO GermanSetup Repository (https://github.com/firegento/firegento-germansetup) kopiert und auch geklont.

Ja, mir ist schon klar, dass der ganze Aufwand mit dem Forken eigentlich überflüssig ist, aber wer weiß wozu es mal gut ist. Ich glaube zwar nicht, dass ich über das reine “Mal reinschauen” hinauskomme, aber wer weiß …

So weit erst mal zur Vorbereitung. Jetzt, da ich alles zusammen habe, was ich für die ersten Schritte benötige, checke ich erst mal, ob der Apache läuft und muss dann mit Hilfe von jumpstorm ein Magento aufsetzen. Vor ein paar Stunden habe ich noch einen Vortrag darüber gehört und bin sehr gespannt, ob ich das nun auch hin bekomme.

Nachdem ich http://localhost/ in die Adress-Zeile meines Browsers eingegeben habe, erscheint der mir bekannte xampp Start Screen und so wie es scheint läuft der Apache (Xampp) perfekt und ich werde mir jetzt mal jumpstore ansehen. Im Hauptverzeichnis finde ich eine PDF Datei mit dem Namen README.pdf. Der Name klingt vielversprechend und ich schaue einfach mal rein. Das PDF ist in englischer Sprache verfasst und erklärt sehr anschaulich mit vielen kleinen Beispielen die Vorgehensweise.

Als erstes sehe ich mir mal die sample.jumpstorm.ini an. Da ich nicht mit sample.jumpstorm.ini arbeiten möchte, benenne ich die Datei um in “jumpstorm.ini” und editiere sie in meinem bevorzugten vim ![]() . Als erstes fällt mir auf, dass hier jemand vor dem einchecken vergessen hat das MySQL Passwort zu entfernen. Eigentlich nicht so schlimm, da es sich bei der Konfiguration ganz offensichtlich um eine lokale Entwicklungsumgebung handelt, aber es wirkt doch erst mal nicht unbedingt vertrauensbildend. Das gleiche gilt auch für das adminPass. Auch hier hätte ich mir eher einen leeren Eintrag gewünscht.

. Als erstes fällt mir auf, dass hier jemand vor dem einchecken vergessen hat das MySQL Passwort zu entfernen. Eigentlich nicht so schlimm, da es sich bei der Konfiguration ganz offensichtlich um eine lokale Entwicklungsumgebung handelt, aber es wirkt doch erst mal nicht unbedingt vertrauensbildend. Das gleiche gilt auch für das adminPass. Auch hier hätte ich mir eher einen leeren Eintrag gewünscht.

Da ich auf den ersten Blick nicht verstehe, was ich in meinem Fall unter “magento” -> “source” eintragen soll, muss ich wohl erst mal in die jumpstorm sourcen schauen. Das ist so oser so erst mal eine gute Idee, denn evtl. baut ein Blick in den Source-Code mein Vertrauen in die Entwickler wieder auf.

Nach dem öffnen der jumpstorm Datei sehe ich auf den ersten Blick das dieses Skript nicht unter Windows entwicklet wurde und daher in meinem Fall einige Anpassungen benötigt. Da es in PHP geschrieben ist, habe ich damit aber wenig Probleme und mache mich erst mal daran, jumpstorm für meine Umgebung anzupassen.

Klar, die Pfade müssen alle angepasst werden, aber ich treffe auch noch auf andere Problem.

1. In der Datei \jumpstorm\lib\Netresearch\Source gibt es eine Methode “isFilesystemPath”, die so erst mal nicht funktioniert – wenigstens unter Windows.

public static function isFilesystemPath($sourcePath)

{

return (0 === strpos($sourcePath, ‘/’)); // path is absolute filesystem path

}

Egal. Ich denke mir mal kleine Änderung – große Wirkung und ändere die Methode ein wenig ab.

public static function isFilesystemPath($sourcePath)

{

return (is_dir($sourcePath)); // path is absolute filesystem path

}

Beim nächsten Test komme ich wieder einen kleinen Schritt weiter. Als nächstes versucht das Script die Dateien per rsync zu kopieren. Das ist eine sehr gute Idee, aber unter Windows doch wieder ein Problem. Bei meiner Suche in den Sourcen finde ich 2 Stellen an denen rsync verwendet wird.

$ grep -r rsync *

lib/Netresearch/Source/Filesystem.php:

$command = sprintf(‘rsync -a -h %s %s 2>&1′, $this->source, $target);

src/Jumpstorm/Extensions.php:

$command = sprintf(

‘rsync -a -h –exclude=”doc/*” –exclude=”*.git” %s %s 2>&1′,

$source . DIRECTORY_SEPARATOR,

$this->config->getTarget()

);

Dabei denke ich natürlich direkt an Clean-Code und Refactoring und …. Aber ich kann mich bremsen und suche kurz mal bei Google nach einer geeigneten Funktion und werde unter http://aidanlister.com/2004/04/recursively-copying-directories-in-php/ fündig. Unter dem Titel Recursively copying directories in PHP hat Aidan Lister eine copyr Funktion veröffentlicht, die – so hoffe ich – auch ihren Zweck erfüllt. Zu dem Zweck habe ich ein weitere PHP Datei unter \jumpstorm\lib\AidanLister angelegt, in der ich die Datei Copyr.php mit der entsprechenden Funktion hinterlegt habe. Beim Test wird klar, warum die Kollegen von netresearch hier auf rsync gesetzt haben, denn das Kopieren der Dateien ist so ungluablich langsam, dass ich in der Zeit auch eben rsync für Windows instalieren könnte.

Nach dem Kopieren der Dateien treffe ich auf das nächste Problem. Der Nächste Schritt versucht die Anlager der MySQL Datenbank. Auch hier wir mit dem exec Kommando gearbeitet und mit Hilfe vom mysql Kommando Datenbanken gelöscht und angelegt. Da der Befehl mysql in meinem Fall nicht im Pfad ist, bekomme ich erst mal nur eine Reihe von Fehlermeldungen. Was dann dazu führt, dass die MAgento Installation mit der folgenden Exception abbricht.

[Exception]

Could not create live database

Also mysql in den Pfad aufnehmen. Bei mir liegt das Kommando mysql unter C:\xampp\mysql\bin und genau das Trage ich dann auch in meine PATH Variable ein. Während mein Test läuft und ich wieder darauf warte, dass die Dateien geladewn werden, lese ich ein wenig über das Symfony Framework. Ich selbst habe es noch nie eingesetzt und nutze die Gelegenheit, mich mal kurz damit zu beschäftigen. Unter http://symfony.com/symfony-in-five-minutes finde ich eine Zusammenfasssung des Symfony Frameworks, dass ich zwar nicht in 5 Minuten lesen kann, aber das Kopieren der Dateien lauft ja auch ein wenig länger ![]() . Na toll. Mittlerweile bin ich zum Senior Symphony Developer geworden und ich sehe wieder nur die Exception. Tja, das hat wohl nicht viel gebracht. Ich greppe noch mal durch die Sourcen nach mysql und sehe, dass es nur eine Stelle gibt, an der das Kommando mysql wirklich benötigt wird. Soll ich einfach den Pfad in der Funktion prepareMysqlCommand ergänzen. Vermutlich wird es klappen, aber so macht das einfach keinen Spaß. Ich sitze ja so oder so hier im Zug fest und erst in Hannover. D.H. ich habe noch ca. 2 Stunden vor mir und daher noch genug Zeit, es richtig zu machen. Geanu in dem Moment geht mir eine Frage durch den Kopf. Warum ist es eigentlich immer so, dass es ungleich länger dauert etwas “richtig” zu machen als es mal eben rein zu fummeln? Die Antwort kenne ich zwar, aber daran will ich mich jetzt nich hoch ziehen. Statt dessen mache ich es richtig unb baue den Pfad zu mysql in die jumpstorm.ini mit ein. Auch wenn ich mir nicht ganz klar darüber bin, ob das schon ausreicht, denn eigentlich währe es noch viel besserm ganz auf den Aufruf von mysql zu verzichten und mit den PHP Methoden mysql_connect und mysql_querry zu arbeiten. Aber das habe ich schon 100 mal gemacht und heute habe ich mal Lust auf was neues.

. Na toll. Mittlerweile bin ich zum Senior Symphony Developer geworden und ich sehe wieder nur die Exception. Tja, das hat wohl nicht viel gebracht. Ich greppe noch mal durch die Sourcen nach mysql und sehe, dass es nur eine Stelle gibt, an der das Kommando mysql wirklich benötigt wird. Soll ich einfach den Pfad in der Funktion prepareMysqlCommand ergänzen. Vermutlich wird es klappen, aber so macht das einfach keinen Spaß. Ich sitze ja so oder so hier im Zug fest und erst in Hannover. D.H. ich habe noch ca. 2 Stunden vor mir und daher noch genug Zeit, es richtig zu machen. Geanu in dem Moment geht mir eine Frage durch den Kopf. Warum ist es eigentlich immer so, dass es ungleich länger dauert etwas “richtig” zu machen als es mal eben rein zu fummeln? Die Antwort kenne ich zwar, aber daran will ich mich jetzt nich hoch ziehen. Statt dessen mache ich es richtig unb baue den Pfad zu mysql in die jumpstorm.ini mit ein. Auch wenn ich mir nicht ganz klar darüber bin, ob das schon ausreicht, denn eigentlich währe es noch viel besserm ganz auf den Aufruf von mysql zu verzichten und mit den PHP Methoden mysql_connect und mysql_querry zu arbeiten. Aber das habe ich schon 100 mal gemacht und heute habe ich mal Lust auf was neues.

Nachdem ich mir nun die Arbeit mit der jumpstorm.ini gemacht habe, muss ich feststellen, dass es alles nichts bringt. Der mysql Befehl wird nun zwar ordnungsgemäß gefunden, aber die Exception bleibt. Mist!

Also weiter Suchen und nicht aufgeben. Vermutlich bin ich wieder einen kleinen Schritt weiter gekommen und darf jetzt nicht aufgeben. Das ist halt das Lehrgeld dass man zahlen muss, wenn man “mal wieder was neues probieren möchte”. OK, ich schaue mir also den Teil in der Base.php noch mal genauer an. Eigentlich kann hier nicht viel passieren und daher entscheide ich mich für eine pragmatische Herangehensweise und gebe einfach mal das erzeugte mysql Kommando aus. Beim Test sehe ich was ich nicht sehen wollte. Das Passwort aus der jumpstorm.ini steht hier im Aufruf. Ach Schei… das habe ich beim vielen Schreiben ja total vergessen. Das PAsswort muss natütrlich raus aus der php.ini, da ich gar kein Passwort für meine lokale xampp Installation nutze. So weit so gut, doch alles jamern und probieren hat keinen Zweck. Irgendwie schaffe ich es nicht, diesen Konstrukt aus mysql.exe und den benötigten Parametern zu übergeben. Ich sehe mir den Return Wert an, der immer 1 statt 0 ist und suche danach bei Google. Evtl. gibt es ja eine Besonderheit unter Windows oder irgendeinen Bug – was weiß ich? Aber nichts. Ich sehe mir das Result des Aufrufs an und bekomme immer eine mysql Hilfe als Result. Das ist sehr verwunderlich und ergibt meiner Meinung nach keinen Sinn, ist aber so. Mittlerweile bin ich fast im Hamm und folge dem was meine Oma immer zu mir gesagt hat. ” Junge, bleib doch lieber bei den bewährten alten Methoden. Das ganze moderne Zeug ist doch nicht gut für Dich”. Eigentlich stimmt es nicht so ganz, denn der aufruf mysql_connect ist jünger als das mysql commando, aber das ist mir jetzt egal und ich baue die Base.php um. In der Magento.php habe ich eine ähnliche Konstruktion entdeckt, um die ich mich jetzt aber noch nicht kümmere. Ich bin mir sicher da werde ich noch ganz von allein drauf treffen. So schaffe ich es dann auch tatsächlich, dass die Datenbank angelegt wird. Hurra! Jetz kann ich also Dateien kopieren und eine leere Datenbank anlegen. Der Nächste Schritt ist die Anlage der Magento Sample Data Tabellen und Inhalte. Auch bei diesem Schritt darf ich mich über eine Exception freuen, was aber daran liegt, dass ich den Punkt noch nicht konfiguriert habe.

[Exception]

Could not detect sample data sql file in source directory git://git.example.org/magento/sampledata.git

Also muss ich nun in der jumpstorm.ini Datei die richtige Lokation der Datei angeben und schon kann es weiter gehen. So lange der Download dauert (Leider habe ich die Zip Datei noch nicht herunter geladen und im Zug ist die UMTS Verbindung leider nicht sehr stabil) schaue ich mir schon mal die Stelle an, die zu der Exception geführt hat. Ich habe ja nun schon eine Menge über jumpstorm gelernt und evtl. hilft mir das Wissen ja weiter.

Siehe da, es ist die Stelle in der Magento.php, die ich gerade noch vor mir hergeschoben habe. Was für ein Wunder. Klar muss hier wieder ein SQL Statement ausgeführt werden und klar ist auch, dass es wieder mit prepareMysqlCommand und exec gemacht wird. Dieses mal ist es aber nicht so einfach wie noch gerade. Ein einfaches DROP DATABASE oder CREATE DATABASE ist doch etwas anderes als eine mehrere 100 MB große SQL Datei einzulesen und dann mit mysql_query auszuführen. Aber ich halte mich an das was meine Oma gesagt hat und versuche, es wieder ohne exec zu machen. Doch aktuell heißt es erst mal Geduld haben und auf den Download warten. In der Zeit google ich das Problem mal. Vermutlich hat so ein Problem schon mal jemand vor mir gehabt und warum soll ich das Rad jedes mal neu erfinden. Dabei fällt mir was ein. Ich habe doch auf der Symphonny Website gelesen, dass es bei einem guten Framework darauf ankommt, dass man das Rad nicht jedes mal neu erfinden muss. Dementsprechend ist das Internet irgendwie auch ein Framework. Man kann es nicht so ohne weiteres benutzen, aber hier findet man auch zu fast jedem Problem eine Lösung, da man so gut wie nie der erste ist, der darauf gestoßen ist … und wenn doch? Dann hat man vermutlich etwas tatal falsch gemacht und sollte lieber alles löschen und noch mal von Vorne anfangen.

So, der Download ist fertig und ich bin in Dortmund. Mist. Selbst mit Verspätung hat die Zeit nicht gereicht. Ich muss in 10 Minuten aussteigen und dann ist erst mal Sense mit Magento2. In den nächsten Tagen werde ich wohl erst mal nicht mehr dazu kommen, hier weiter zu arbeiten. Außerden sehe ich keinen Grud darain, mein Netbook in die Hand zu nehmen, wenn ich einen richtigen Rechner habe.

So wie es aussieht ist das der Punkt an dem ich erst mal aufgeben muss. Ja, ich weiß, dass Magento nicht für Windows gemacht wurde und das hat so wie es scheint auch einen Hintergrund ![]() . Ich werde das ganze wohl noch mal in Ruhe auf einem Linux Server probieren und gebe damit zurück an die anderen Webseiten.

. Ich werde das ganze wohl noch mal in Ruhe auf einem Linux Server probieren und gebe damit zurück an die anderen Webseiten.

Related posts:

- Google Website Optimizer Der Google Website Optimizer ist ein online Tool von Google, mit dem man testen kann, ob durch Änderungen der Webseite...

- svg2png mit gimp auf der Konsole Nachdem ich festgestellt habe, dass sich ImageMagick nicht immer optimal dazu eignet, svg Dateien in jpg oder png Dateien umzuwandeln,...

- MySQL “ERROR 2006 (HY000) at line 270: MySQL server has gone away” Beim Inport von großen Dateien kann der folgende Fehler auftreten. “ERROR 2006 (HY000) at line 270: MySQL server has gone...

Ich bin dabei und freue mich schon darauf. Auch wenn ich dann einmal in der Woche den Akku meiner Uhr aufladen muss.

Leider muss ich noch bis September warten. Erst dann ist Pebble fertig. Bis dahin muss meine Uhr noch durchhalten ![]()

No related posts.

]]>Diese Topliste hat einiges zu bieten, das über die Funktionalität von klassischen Toplisten weit hinaus geht.

Die Featured Website

Die Featured Website ist ein besonderer Platz, den Webmaster sich durch das Schreiben von Bewertungen der anderen Mitglieder erarbeiten können. So entsteht eine Community und die Mitglieder lernen sich untereinander auch ein wenig kennen. (Details zur Featured Website)

Individuelle Newsletter

Die Topliste kann individuelle Newsletter für jedes Mitglied erstellen und versenden. So kann man in den Newslettern den aktuellen Punktestand und das Ranking in der Top100 per Mail mitteilen. (Dies ist die letzte Funktion, an der ich momentan noch arbeite ![]() ).

).

Modernes Design

Das Design der Topliste wurde mit einem modernen Design Template ausgestattet und mit Hilfe von jQuery und netten, kleinen Animationen aufgefrischt. Besuche einfach mal die Top100 unter http://top100-web.de/ und mache dir selbst ein Bild von der Seite.

Fadeout Web 2.0 Thumbshots

Statt der üblichen 468×60 Banner werden hier die Web 2.0 Thumbshots von fadeout.de verwendet. So kann ich sicher sein, dass keine “broken images” auf der Webseite angezeigt werden, wenn mal wieder ein Webmaster seine Website aus dem Netz genommen hat oder das Banner gelöscht hat.

Fake-Hit Erkennung

Dank einer ausgeklügelten Logik ist es nicht mehr möglich, mit Hilfe von Robots und anderen Tricks das Ranking zu manipulieren. Cheating wird sehr schnell erkannt und kann zum Ausschluss der Webseite aus den Top100 führen.

Nutzung von Ping Diensten

Dank der Nutzung einiger beliebter Ping-Dienste sind Einträge die in der Top100-Web.de freigeschaltet wurden innerhalb weniger Minuten bei Google im Index gelistet.

Dofollow Links

Mitglieder, die ihre Webseite in die Topliste eingetragen haben erhalten dafür einen dofollow Link von der Mitglieds Seite. Die Featured-Website erhält sogar einen PageRank 5 Startseiten Link für mindestens einen Monat.

Einfache Anmeldung

Die Anmeldung in der Top100 ist sehr schnell und einfach möglich. Es müssen nur wenige Felder in dem Formular unter http://top100-web.de/seite-eintragen/ ausgefüllt werden um Mitglied in der Top100-Web.de Community zu werden.

Rich Snippets für Bewertungen

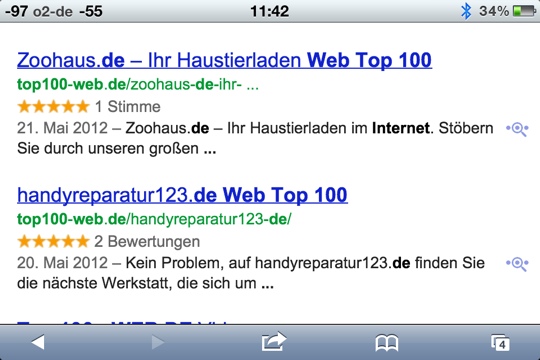

Die Topliste unter Top100-Web.de verwendet auch die sog. Rich Snippets für Bewertungen. So können deutlich erhöhte Kilckraten auf die Mitlieder-Seiten in den Google Ergebnissen erzielt werden. Siehe Beispiel 1.

Beispiel 1: Toplisten Eintrag mit einer Bewertung in den Google Suchergebnissen

Darüber hinaus gibt es noch eine Reihe andere Features. Melde deine Webseite doch einfach unter http://top100-web.de/seite-eintragen/ an und finde selbst heraus, was die Topliste alles so kann ![]() .

.

Natürlich freue ich mich immer über konstruktive Kritik, Anregungen und Lob. Hinterlasse einfach hier einen Kommentar.

Related posts:

- 350 Code-Beispiele für WordPress Im WordPress-Newsletter Nr. 39 von perun.net gabe es heute einen Hinweis zu 350 Code-Snippets für WordPress. Genau so was brauche...

- Google Website Optimizer Der Google Website Optimizer ist ein online Tool von Google, mit dem man testen kann, ob durch Änderungen der Webseite...

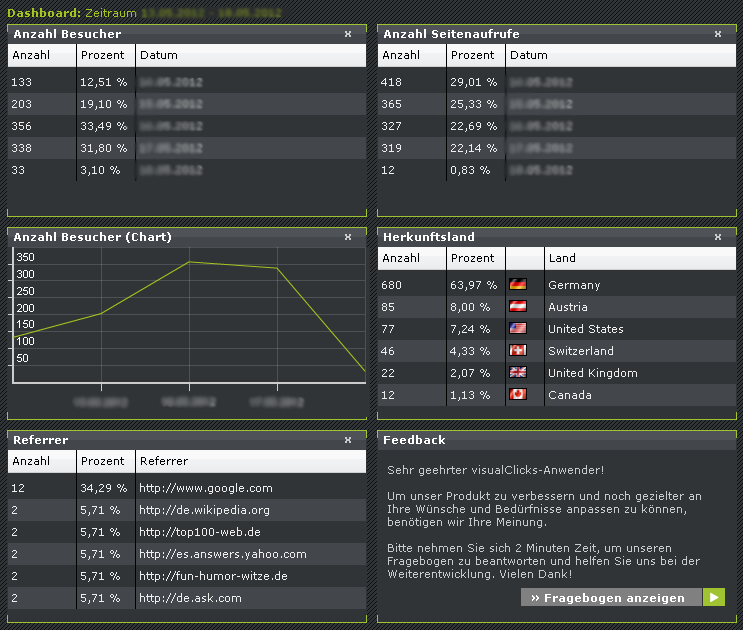

VisualClicks Webstatistik & SEO-Tools Dashboard

Nach dem Login gelangt man zum Dashboard. Das Dashboard kann frei definiert werden und es ist möglich, 6 Informationen im Dashboard aufzunehmen, die man aus der folgenden Liste auswählen kann.

- Besucherzahlen nach Datum gruppiert

- Seitenaufrufe nach Datum gruppiert

- Besucherzahlen nach Datum gruppiert (als Diagramm)

- Suchbegriffe, die zu Ihrer Webseite geführt haben

- Browser

- Herkunftsland der Besucher

- Referrer, die zu Ihrer Webseite verlinken

- Suchmaschinen, die zu Ihrer Webseite geführt haben

- Städte, aus denen Ihre Besucher kommen

- Bundesländer, aus denen Ihre Besucher kommen

- Bundesländer (Karte), aus denen Ihre Besucher kommen

- Top-Seiten Ihrer Webseite, die aufgerufen werden

- Verweise von Social-Networks

In der Standard Ausprägung erhält man erst mal die Besucherzahlen nach Datum, die Seitenaufrufe nach Datum und die Besucherzahlen nach Datum. Ich habe noch ein wenig damit gespielt und mich für das folgende Dashboard entschieden.

Mein Dashboard

In der Haupt-Navigation gibt es 3 Bereiche “Account”, “Statistik” und “SEO”. Unter Account kann man sein persönlichen Daten pflegen und das Dashboard definieren. Unter Statistik kann man sich das Dashboard anzeigen lassen und detaillierte Berichte zu Besucherstatistik, Seitenaufrufe, Umsatzstatistik und Besucher online anzeigen zu lassen. Die Umsatz-Statistik ist nicht im kostenlosen Paket enthalten, daher kann ich hierzu nicht viel sagen. Allerdings habe ich auch keine E-Commerce Seite und mache ja auch keine Umsätze. Also ist es mir auch egal. Der Punkt “Besucher online” ist aber nicht uninteressant. Hier kann man sich auf einer Karte ansehen, woher die Besucher kommen. Man kann beliebig zoomen, wie man es von Google Maps her kennt. Hier mal die Karte meine Besucher, die gerade online sind. Einmal von der ganzen Welt und dann nur aus Deutschland.

Besucher-Karte von VisualClicks

Im Bereich SEO hat man die Möglichkeit einen Domainvergleich zu erstellen, eine Seitenanalyse durchführen zu lassen und einen Domainreport anzuzeigen. Alle 3 Funktionen haben sehr viel zu bieten und mit den hier angezeigten Informationen kann man die eigene Webseite sehr gut optimieren und sein Google Ranking verbessern.

VisualClicks kosteloses Webstatistik & SEO-Tool

Für ein kostenloses SEO-Tool ist es wirklich sehr umfangreich, schnell und stabil. Auch wenn ich das Tool erst seit ein paar Tagen im Einsatz habe, ist mein erster Eindruck doch sehr gut und ich kenn es jedem Webmaster nur empfehlen. Gerne hätte ich mir auch mal die Heatmaps angesehen, aber die ist nicht im kostenlosen Angebot enthalten.

PS: Auch ohne Anmeldung ist eine Domainbewertung der eigenen Domain möglich. Einfach auf den Link klicken und eine umfangreiche Domain-Bewertung durchführen lassen.

Related posts:

- 2 neue Mini-Tools zum Encoding und Decoding von URLs Ich habe 2 neue Mini-Tools entwickelt, die eigentlich nichts besonders machen. Das eine ist ein urlenoder und das andere ist...

- Monatliche lokale Suchanfragen des Google Keyword Tools Da ich seit einiger Zeit wieder Google Analytics verwende habe ich mir mal die Zeit genommen und mir die Google...

Wie mir scheint sind viele dieser Webmaster nun wieder in Foren unterwegs und versuchen Hilfe von den selbsternannten Experten zu bekommen.

Ob das immer so klappt? Naja, jeder muss selber wissen wie viel ihm seine Website wert ist.

Tja wie komme ich eigentlich darauf? Naja, ganz offensichtlich wird den Webmastern in Foren und Blogs geraten, erst mal die ganzen (potentiell gefährlichen) Backlinks aufzuräumen, denn ich bekomme nun seit Wochen ständig Mails wie z.B. das folgende Beispiel.

————————————–

Titel: Bitte den Kommentar Link entfernen

Inhalt:

Guten Tag Herr Jentsch,

hiermit möchte Ich Sie bitte den Link zu www.########.de in diesem Kommentar von mir zu entfernen oder auf nofollow zu setzen:

http://meinblog.de/meinartikel

Vielen Dank für Ihre Mühe schonmal und beste Grüße,

VERZWEIFELTER WEBMASTER

——————————————–

So oder so ähnlich klingen alle diese Mails die mir momentan ganz schön viel Arbeit machen.

Da ich nun mal eine Reihe von dofollow Links betreibe (von denen 2 sehr alte Projekte auch etwas abgerutscht sind) bekomme ich auch sehr viele dieser Mails. Anfangs habe ich es nicht verstanden, bis ich dann mal bei einem der verzweifelten Webmaster nachgefragt habe. Dann war alles klar. Irgendwie tun sie mir ja auch leid, einige von ihnen leben von den Besuchern, die sie auf ihrer Webseite haben und ich bin auch immer bemüht, die Links zeitnah zu entfernen, aber teilweise kann es halt ein wenig dauern. Sorry

Allerdings glaube ich nicht, dass es etwas bringt, wenn man die Links aus Blog Kommentaren entfernen lässt (Im besten Fall nützt es dem Webmaster des Blogs mit dem ausgehenden Link, wenn der Link entfernt wird um Bad Neighborhood zu vermeiden). Ausserdem ist es für den Blog Betreiber auch immer eine Grad-Wanderung solche Kommentare zu verändern.

Wie stelle ich als Blogger denn zum Beispiel sicher, dass der Sender der E-Mail wirklich ein verzweifelter Webmaster ist und nicht ein Konkurrent, der dem Autor des Kommentars nur Schaden will? Tja, laut deutschem Recht liegt das Copyright des Kommentars beim Autor und ich darf genau genommen gar keine Änderung daran vornehmen … so sieht es aus. Schon mal darüber nachgedacht?

Bleibt also genau genommen nur noch die Möglichkeit den Kommentar komplett zu entfernen. In einigen Fällen ist das nicht so schlimm, da viele der Kommentare kaum Mehrwert für den Leser bieten, aber einige Kommentaren habe ich nur sehr ungern entfernt oder beim Autor nachgefragt, ob der Kommentar auch ohne den Link erhalten bleiben darf.

Bleibt nur zu hoffen, dass es bald wieder ein neues Update gibt und dann dofollow Links aus Blog Kommentaren wieder angesagt sind. ![]()

Noch was in eigener Sache: Dieser Blog hat beim letzten Update wieder mal Besucher hinzugewonnen. Ob er besser rankt weiß ich nicht, aber die Besucherzahlen sind mal wieder gestiegen. Ich betreibe auch kein Offpage SEO für den Blog, da es wohl auch sinnlos währe. Denn diese Webseite ist nur meine Spielwiese. Ich verkaufe weder etwas noch habe ich massenweise Affiliate Links geschaltet. Ich versuche nur die Server Kosten zu decken, die der kostenlose Thumbshots Dienst nunmal verursacht.

PS: Ich freue mich schon auf die Kommentare von euch. Egal ob mit oder ohne Backlink.

Related posts:

- Onkelseoserbe SEO Wettbewerb Auch wenn ich bisher nicht bei dem SEO Contest zum Thema Onkelseoserbe teilnehme, möchte ich doch mal einen kleinen Test...

- Dofollow Backlinks mit dem Google Reader Backlinks sind noch immer das Beste und Wichtigste, wenn es darum geht, bei Google ein brauchbares Ranking zu erhalten. Ohne...

- DoFollow-Blogs bekommen mehr Kommentare Nachdem meine Webseite ja nun schon einige Jahre auf dem Buckel hat und schon viele CMS und Blog Systeme gesehen...